Skip to main content

Medienberichte über US-Sicherheitsprogramm

VS2015 Remote Debugging JavaScript – Part 2

VS2015 Remote Debugging JavaScript Hosted in Web Browser Control

Earlier we talked about how to debug JavaScript remotely from Internet Explorer process. This one does not differ at all from it. All you need to do is select different target process. If you haven't read the post, then here is the link.

https://blogs.msdn.com/b/prakashpatel/archive/2015/10/23/vs2015-remote-debugging-javascript.aspx

I'll start from the step that assumes that all the configuration is taken care of. If you run into any issues, then you may want to read the FAQ section in the previous blog.

Sample HTML Page

Here is a sample HTML page that I'm using for debugging – it is very basic. I have saved it as TestLeak.html.

<!DOCTYPE html>

<html>

<head>

<style>

body.segoe {

font-family: "Segoe UI", Verdana, serif;

}

</style>

<script type="text/javascript">

function throwError() {

document.getElementById("LeakedDiv").appendChild("<p>It worked!</p>"); // Misspelled LeakedDiv (L is upper case)

}

</script>

</head>

<body class="segoe" id="leakedDiv">

<div>

<input id="btnThrowError" type="button" value="Throw an error" onclick="throwError()" />

</div>

</body>

</html>

Start Visual Studio

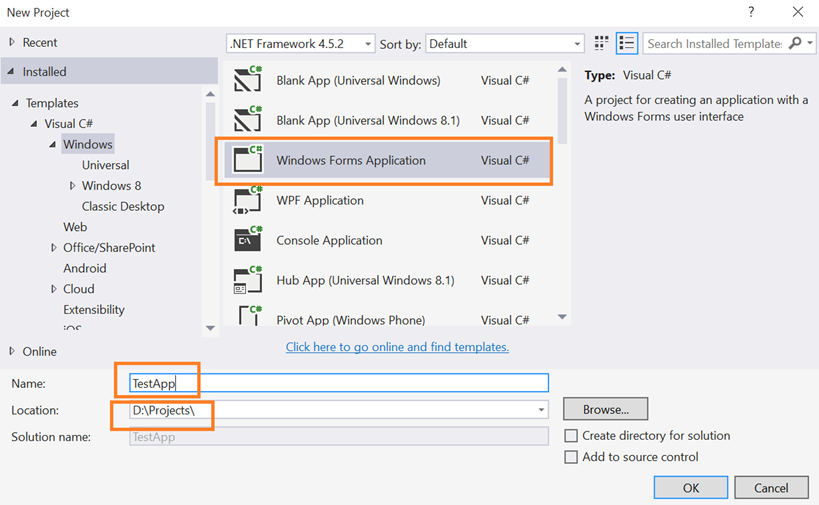

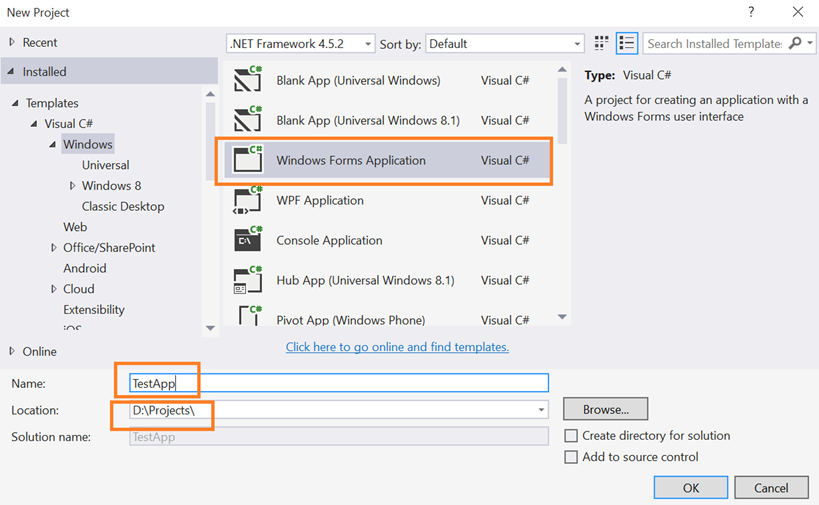

To create a sample WinForms application

- From Start Screen: Click on New Project… or

- From Menu: File à New… à New Project… or

- Keyboard Shortcut: Control + Shift + N

I'm choosing TestApp as name but you can choose any other name. You may specify additional configuration if desired. Click on OK to continue.

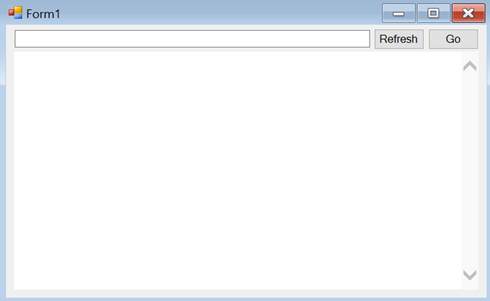

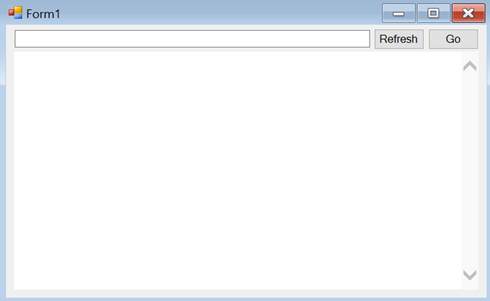

Create a simple form with 2 button, 1 textbox and a WebBrowserControl on the form as shown. Rename them as shown below. You can also drop status bar on the form if you like.

Add following line of code to the event handlers for Refresh and OK button. You can double click on the buttons to add event handlers

private void button1_Click(object sender, EventArgs e)

{

if (!String.IsNullOrWhiteSpace(textBox1.Text))

webBrowser1.Navigate(textBox1.Text);

}

private void button2_Click(object sender, EventArgs e)

{

webBrowser1.Refresh(WebBrowserRefreshOption.Completely);

}

- Now compile and copy the binary (TestApp.exe) to the target machine.

Connecting VS2015 to VS2015 Remote Debugger on Target Machine

Start Sample WebBrowser application on the target machine where you just now installed VS2015 Remote Debugger.

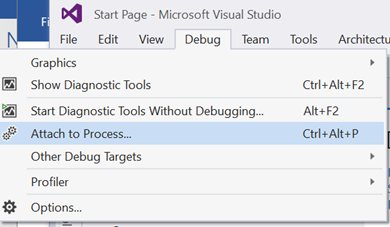

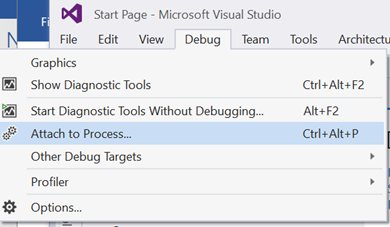

On VS2015 Machine, open VS2015. Click on Debug ? Attach to Process…

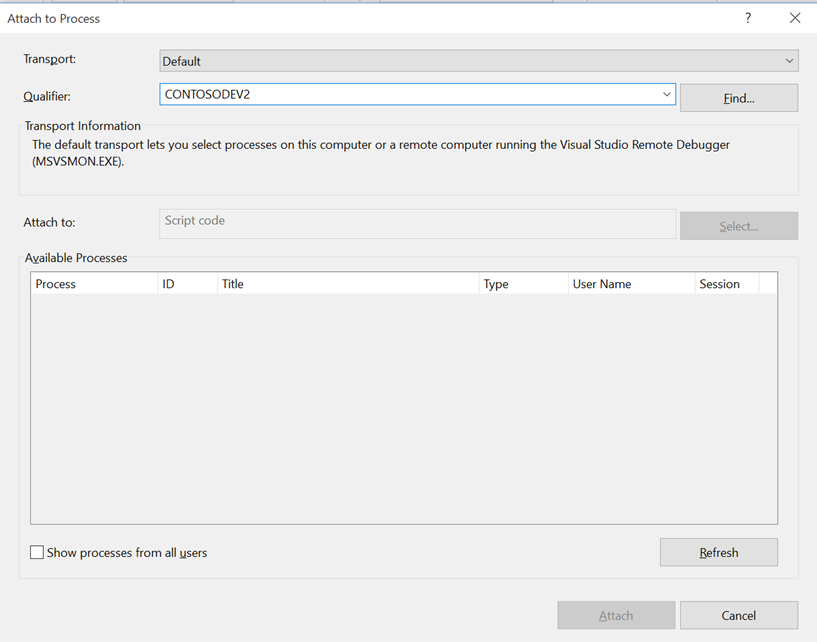

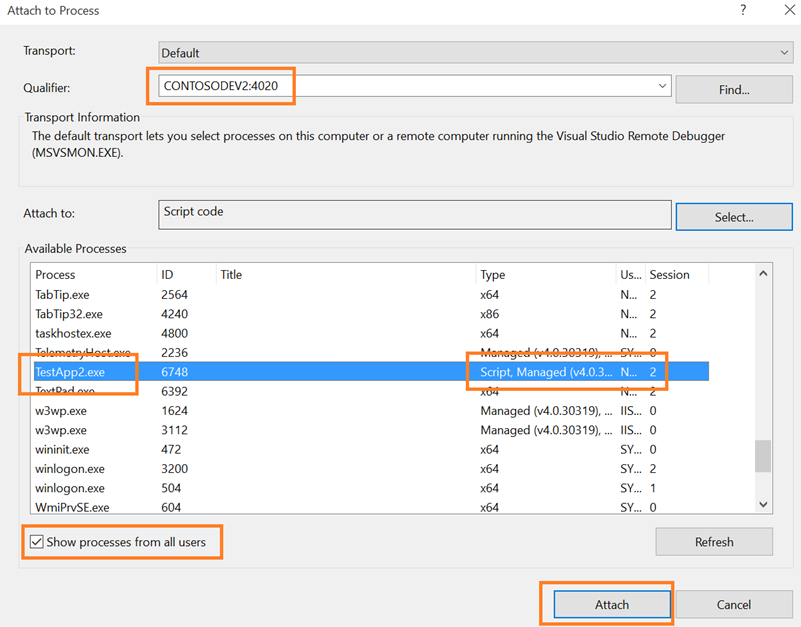

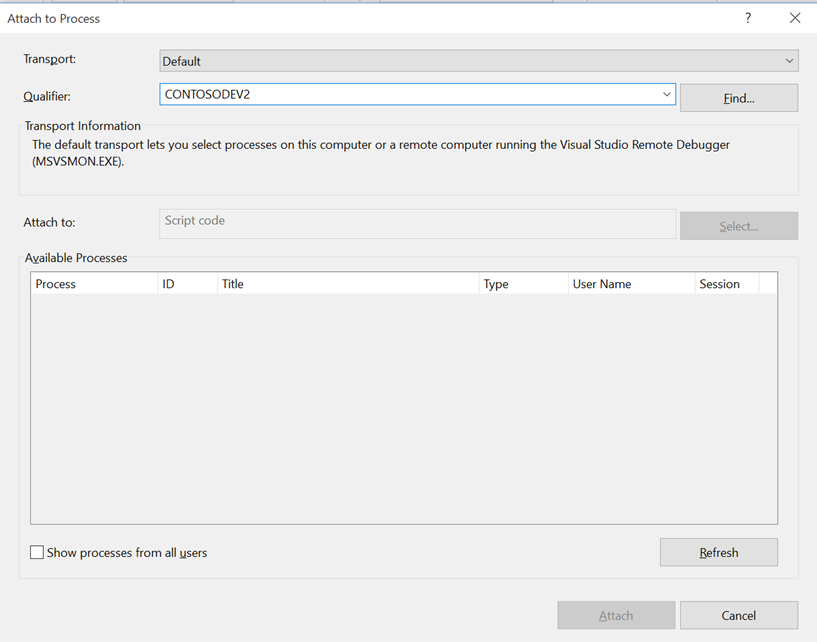

On the Attach to Process window, specify target machine name in the Qualifier textbox. Or click on Find… button to find the machine in the domain. I'm connecting to my test machine named ContosoDev2.

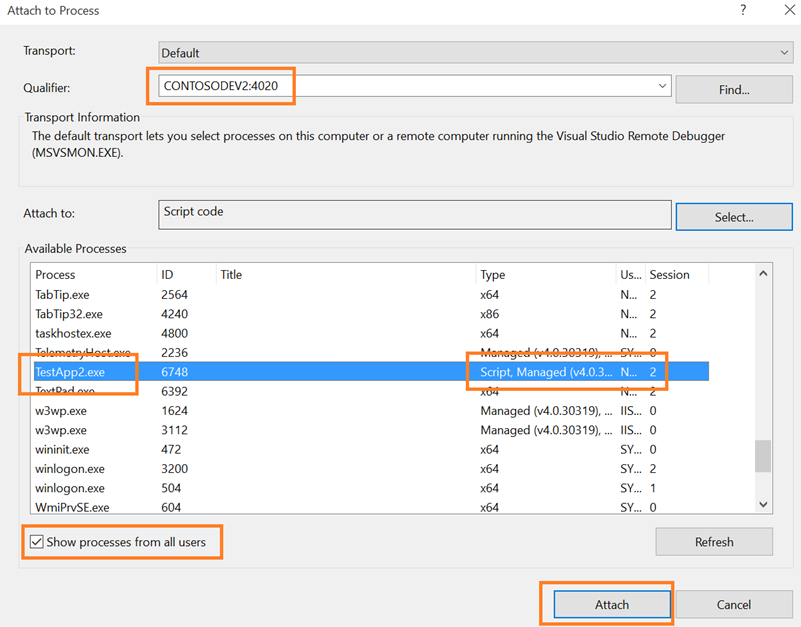

By default, the list will not be refreshed so click on Refresh button to see the list of running processes. You may want to select Show processes from all users if you need to debug process launched by another user.

Note:

- If you configured Remote Debugger to run under LocalSystem account (or accepted default settings) then, you'll have to select Show processes from all users option to view your processes. As it will only list processes running under SYSTEM account in all sessions.

- The Qualifier may change from ContosoDev2 to Contosodev2:4020.

- Make sure you select Script code as debugging option or Attach to as shown in the screenshot.

Select the target process and click on Attach button. Make sure Script is displayed next to the target process. By default Script and Managed code debugging will be selected by VS2015.

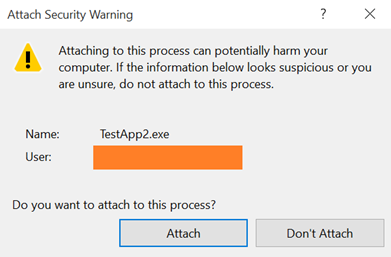

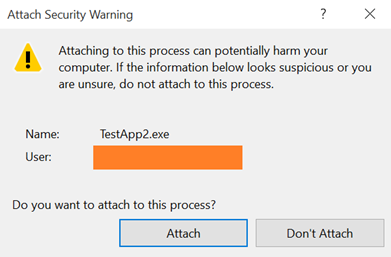

Visual Studio warns you against potential security compromise that may happen when you attach to a remote process. If you know the target process and site it has navigated to click on Attach to continue.

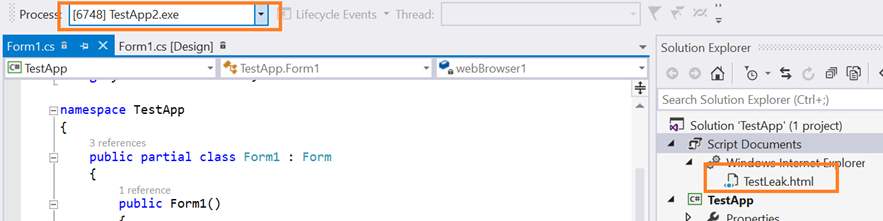

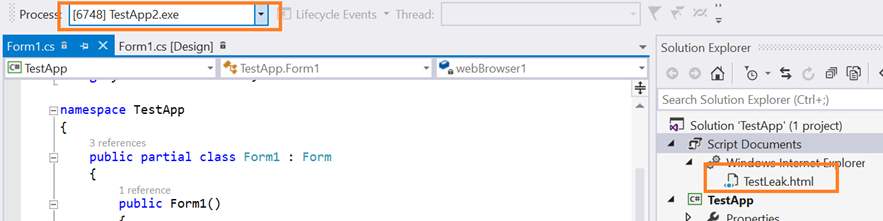

After the connection is successful, you should see TestLeak.html page in the VS2015 Solution Explorer.

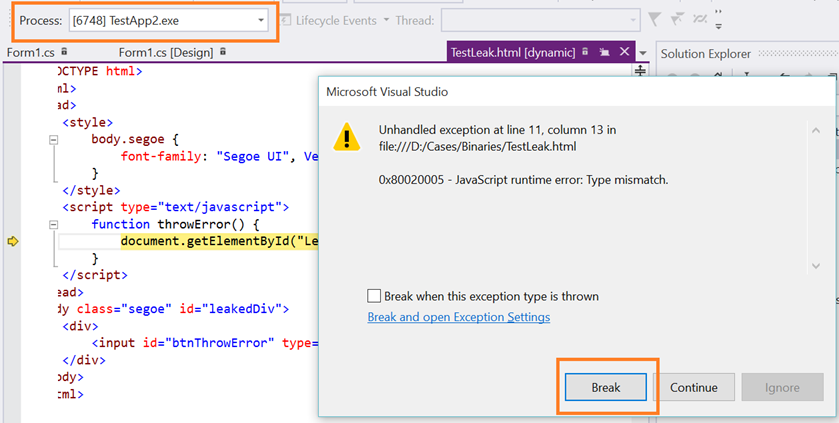

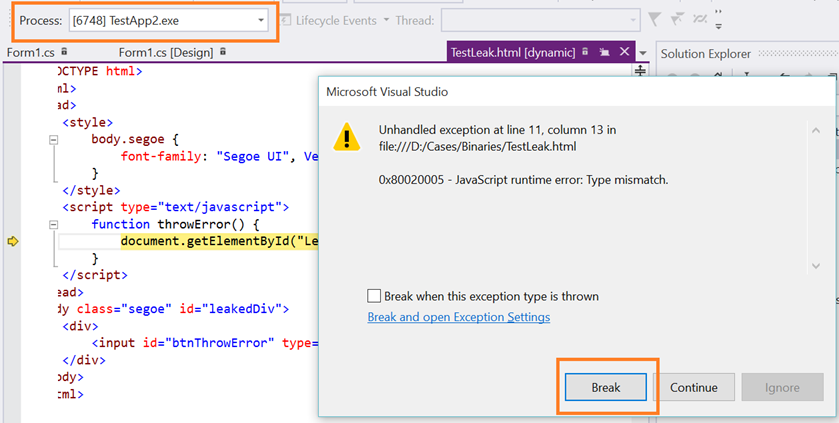

Now, click on Throw an error button.

It should break in the debugger.

The goal here is to make you familiar with the tool feature. Hope you find it useful.

Sample Source Code and Project

You may want to rename TestLeak.html.txt to TestLeak.html

TespApp.zip

TestLeak.html

VS2015 Remote Debugging JavaScript – Resources

Some of the resource I have found useful in the past. I'll keep updating the list as and when I find good article. Please feel free to send me your list too!

What's New in F12 for "Project Spartan" by Andy

F12 developer tools MSDN article

- Inspect running JavaScript with the Debugger

- Diagnosing memory problems in your webpages

If you are a debugging guru and you like to deal with bit and bytes then you may find following blog useful. Starting with Windows 8, you can identify JavaScript function or line of code that was executing when the dump was captured.

Finally... JavaScript source line info in a dump

You can also use standalone tools like PerfView (no installation required) to identify offending JavaScript code.

PerfView does JavaScript investigations too

DebugDiag is another tool you may want to become familiar with. It allows you to automate some of the debugging work so you can spend more time designing and developing applications.

- Debug Diagnostic Tool – Blog

- The DebugDiag 2.0 Team

Note: You may blogs published by my colleagues and me at PFE – Developer Notes for The Field.

2. Microsoft Polizeisymposium in Berlin - Mobile Policing: Neue Technologien und Geräte für die mobile Polizeiarbeit

Ein Großteil der Polizeiarbeit findet naturgemäß außerhalb von Dienststellen und abseits vom Schreibtisch statt. Hier ist entscheidend, die Mitarbeiter im mobilen Einsatz mit effizienten, zuverlässigen und sicheren Technologien sowie mit geeigneten Geräten zu unterstützen.

Ich lade Sie deshalb herzlich zu unserem Symposium zum Thema „Mobile Policing" am 27. November 2013 bei Microsoft in Berlin ein.

Machen Sie sich im Rahmen des Polizeisymposium Berlin 2013 selbst ein Bild von der Leistungsfähigkeit und Zuverlässigkeit der neuesten Technologien und Geräte. Microsoft und seine Partner bieten Ihnen dabei einen umfassenden Einblick in die Thematik, von der App-Entwicklung, dem Aufbau von sicheren Infrastrukturen, der Berücksichtigung des Datenschutzes, der Vorbeugung von Missbrauch und der Beweiswerterhaltung bis hin zum Einsatz von Tablets-PCs. Ergänzend präsentieren wir Ihnen eine Auswahl von Windows Phone und Tablet-PCs, inklusive ruggedized Geräten und natürlich stellen wir Ihnen auch die Microsoft Surface Familie vor.

Ihre Agenda

Uhrzeit | Programm |

9.30 Uhr | Registrierung, Frühstück und Führung durch die Räumlichkeiten von Microsoft Berlin und The Digital Eatery, Café und Showroom Hier können Sie selbst Hardware, Software & Services erleben und ausprobieren |

10.00 Uhr | Begrüßung Thomas Lipp, Senior Business Development Manager, Microsoft Deutschland GmbH |

10.10 Uhr | Überblick über Mobile Policing Thomas Lipp, Senior Business Development Manager, Microsoft Deutschland GmbH |

10.30 Uhr | Von der Idee zur App und deren Entwicklung mit dem XD-Studio Rene Rösel, Solution Sales Professional, Microsoft Deutschland GmbH Karsten Lutter, Director, Avanade Deutschland GmbH |

10.50 Uhr | Ordnungswidrigkeiten-App für Windows Phone und Surface Karsten Lutter, Director, Avanade Deutschland GmbH |

11.10 Uhr | Aufbau einer sicheren Infrastruktur für Mobile Policing Markus Kobe, Senior Technologieberater, Microsoft Deutschland GmbH Thomas Kuklowski, Senior Technologieberater, Microsoft Deutschland GmbH |

11.30 Uhr | Mobile und sichere Datenabfragen inkl. hochauflösender Fotos Alex Becker, Managing Consultant, Alegri International Service GmbH |

11.50 Uhr | Mobilität mit Surface und Windows Tablets Gregor Kolk, Surface Produktmanager, Microsoft Deutschland GmbH |

12.10 Uhr | Ruggedized Tablet-PCs für den polizeilichen Einsatz Dónal Ó Donnabháin, Senior Manager Sales, Intel Mobile Communications |

12.30 Uhr | Mittagessen und begleitende Ausstellung von Devices |

13.30 Uhr | Mobile Karten Mareike Kortmann, Account Manager BOS, ESRI Deutschland GmbH |

13.50 Uhr | Kundenvortrag zum Einsatz von mobilen Geräten im täglichen Polizeieinsatz |

14.10 Uhr | Sichere Identitäten und Beweiswerterhaltung mit Truedentity Steffen Sklebitz, Sales Manager, OpenLimit SignCubes GmbH |

14.30 Uhr | Mobile Asservaten Thomas Bley, Account Manager, OPTIMAL SYSTEMS Vertriebsgesellschaft mbH |

14.50 Uhr | Mobiles, integriertes Bildungsmanagementsystem Marcus Schubert, Business Development Manager, T-Systems MMS |

15.10 Uhr | Infrastrukturlösungen eines Carriers Heiner Jung, Key Account Manager, Vodafone GmbH |

15.30 Uhr bis ca. 17.00 Uhr | Ende der Veranstaltung, Get Together und begleitende Ausstellung von Devices |

Um einen möglichst intensiven Austausch zwischen Teilnehmern und Referenten zu gewährleisten, sind die Kapazitäten begrenzt. Eine schnelle Anmeldung ist zu empfehlen. Melden Sie sich deshalb am besten noch heute zum kostenfreien Polizeisymposium Berlin 2013 an.

Falls Sie Fragen zu diesem Angebot haben, freue ich mich auf Ihre Kontaktaufnahme. Wenn Sie in Zukunft keine weiteren Empfehlungen zu Microsoft Veranstaltungen erhalten möchten, geben Sie mir bitte kurz Bescheid. Zudem können Sie die Art und Weise wie Microsoft mit Ihnen in Kontakt treten soll hier ganz leicht selbst bestimmen.

Ich freue mich schon jetzt sehr darauf, Sie persönlich in Berlin zu begrüßen und wünsche Ihnen weiterhin viel Erfolg bei Ihren Projekten.

Mit freundlichen Grüßen

Thomas Lipp

Senior Business Development Manager

Microsoft Deutschland GmbH

Auf den Hund gekommen - aktuelle Schritte zur künstlichen Intelligenz

Letzten Monat hat die Universität von Reading verkündet, dass erstmals ein Computer den vor 64 Jahren definierten Turing Test bestanden hat. Alan Turing, ein britischer Mathematiker und Informatiker, hatte diesen Test im Jahr 1950 vorgeschlagen, um festzustellen, ob eine Maschine ein dem Menschen ebenbürtiges Denkvermögen besitzt. Der Test soll also der Feststellung von künstlicher Intelligenz dienen und Turing erwartete, dass er im Jahr 2000 bestanden werden könnte.

Kurz gesagt geht es darum, ob menschliche Fragesteller in einer fünfminütigen, freien Konversation über Tastatur und Bildschirm zu mehr als 30% nicht mehr zwischen einem menschlichem Gegenüber oder einem Computer als Gesprächspartner unterscheiden können. Ob sich mit diesem Test nun tatsächlich künstliche Intelligenz feststellen lässt ist inzwischen umstritten und die Testbedingungen in Reading waren sicherlich auch etwas eigenwillig (hier mehr zum Turing Test).

Was sich aber unzweifelhaft feststellen lässt: Die unbelebte Welt um uns herum fühlt sich zunehmend intelligenter an. Dem Smartphone oder Tablet in unserer Hand ist „irgendwie bewusst", wo es sich befindet, welche Tageszeit wir haben, wie das Wetter gerade ist und unsere persönlichen, digitalen Assistenten „wissen" und teilen uns mit, dass wir aufgrund eines Verkehrsstaus früher als sonst zum Flughafen aufbrechen sollten oder dass wir heute vielleicht mal wieder zu wenig Bewegung hatten.

Möglich wird dies alles durch Sensoren, deren Vernetzung und eine Vielzahl von lernenden Algorithmen, die „Erkenntnisse" ermöglichen, inzwischen eben auch für alle Arten von Computern.

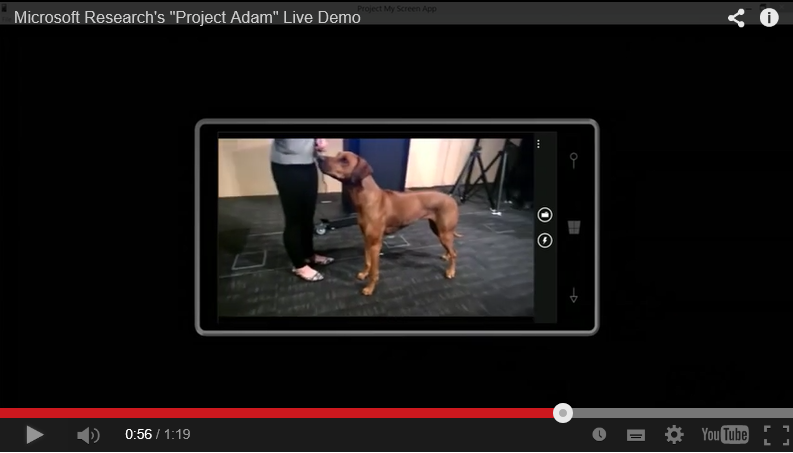

Wie weit wir damit bereits sind, zeigt eindrucksvoll und aktuell das „Projekt Adam" von Microsoft Research, in dem ein neuronales Netzwerk durch eine Vielzahl von Servern in der Microsoft Azure Cloud aufgebaut wird. Dieses Netzwerk ist in besonderem Maße lernfähig, da es asynchron arbeiten und quasi Analyse-Unteraufgaben im Netzwerk verteilen kann, die weitgehend unabhängig voneinander gelöst werden und danach zu einer „Gesamterkenntnis" verschmolzen werden.

Beeindruckend ist das Ergebnis in diesem kurzen Demo-Video, in dem Cortana, Microsoft's persönliche Assistentin auf dem Windows Phone, sich die Lernfähigkeiten von Projekt Adam zunutze macht, um zuverlässig Hunderassen zu erkennen.

Übrigens hat Cortana auch die Gewinner aller Endrundenspiele der Fußballweltmeisterschaft richtig vorher gesagt.

Das sich entwickelnde „Internet der Dinge" wird uns auf dem Weg zu künstlicher Intelligenz deutlich weiter bringen. Eine unglaubliche Zahl unterschiedlicher, miteinander vernetzter Sensoren, gigantische, verteilte Verarbeitungs- und Speicherkapazitäten, effiziente Algorithmen zur Analyse und Interpretation – diese Beschreibung vom „Internet der Dinge" passt eben auch auf das menschliche Gehirn.

Big Data – Das neue IT-Paradigma?

Big Data ist in aller Munde – das beweist die große Anzahl der Beiträge auf Blogs, in Fachzeitschriften und Magazinen, aber auch die Vielzahl durchgeführter Umfragen und Unternehmen, die sich mit dieser Thematik auseinandersetzen. In den nächsten Wochen widmen wir uns an dieser Stelle verschiedenen Fragestellungen: Was klassifiziert Data als Big Data? Impliziert Big Data Big Security? Gehen Open Data und Big Data Hand in Hand? Gibt es einen Zusammenhang zwischen der Cloud und Big Data? Ein Annäherungsversuch an den Begriff Big Data soll der Startschuss unserer kleinen Big Data-Reihe sein.

Wann spricht man nun eigentlich von Big Data"? Um diese Frage zu beantworten wird oftmals auf die „3Vs" – Volume, Variety und Velocity – zurückgegriffen, die im Folgenden genauer erläutert werden.

• Volume – Verschiedene Studien belegen ein stetiges Datenwachstum, sodass sich das im Jahr weltweit erzeugte Datenvolumen mittlerweile im Bereich von Zetabytes (1021 Byte) bewegt und weiter ansteigt. So wird Big Data vom McKinsey Global Insitute beispielsweise definiert als Datensätze, deren Größe über die Fähigkeit von typischen Software Werkzeugen für die Erfassung, Speicherung, Verwaltung und Analyse hinausgehen.

• Variety – Die unterschiedlichen Datenquellen und Datenformate sind ein weiteres Charakteristikum von Big Data. Es geht demnach um die Erfassung, Speicherung, Verwaltung und Analyse von strukturierten, unstrukturierten, dynamischen oder statischen Daten unterschiedlichen Ursprungs. Die Auswertung und Nutzung von Daten aus verschiedenen Social Media Kanälen ist ein interessanter Zugang, um Einblicke in gewisse Situationen, wie Krisen oder Meinungen zu öffentlichen Belangen oder Beschlüssen, zu erhalten.

• Velocity – Das dritte V bezieht sich auf die hohe Geschwindigkeit mit der die großen Datenmengen unterschiedlicher Formate und verschiedenen Ursprungs anfallen und zu erfassen, zu speichern, zu verwalten und zu analysieren sind. Die Analyse und Nutzung von Echtzeitdaten kommt besondere Bedeutung zu. Als Beispiel kann hier die Erfassung von Fahrzeugpositionen im Straßenverkehr zur Umgehung von Staus genannt werden.

Big Data ist in aller Munde – aber ist das Thema auch für die öffentliche Verwaltung von Relevanz? Ja! Gegenüber dem Behörden Spiegel äußerte Franz-Reinhard Habbel, Sprecher des Deutschen Städte- und Gemeindebundes, dass es bislang um Hardware und Software gegangen sei und nun ein Wandel hin zu Inhalten, also der Analyse und Auswertung von Daten, Informationen und Wissen, stattfindet. Auch in weiteren Beiträgen wird Big Data als ein wichtiges Thema für die Verwaltung von heute angesehen. Hier wird vor allem auf die Vorteile der Nutzung von Big Data in Bezug auf „ […] operative Effizienz, die Bekämpfung von Korruption und Kriminalität sowie […] [die] Umsetzung der Rechenschaftspflicht [...]" hingewiesen. Auch die Nutzung entsprechender Analysen in Krisensituation wird thematisiert.

Die Relevanz von Big Data auch im öffentlichen Bereich möchten wir zum Anlass nehmen und Ihnen kommende Woche ein paar konkrete Einsatzbeispiele vorzustellen.

Geposted von Rüdiger Dorn und Magdalena Theisen

Big Data – Ein Thema für die Informations-Sicherheit?

Als Fortsetzung unserer Big Data Reihe und den Beiträgen zu Definition und der Aufzählung von einigen Beispielen soll heute das Thema Sicherheit beleuchtet werden. So steht die Frage „Ein Thema für die Informationssicherheit?" im Mittelpunkt.

Bereits im Blog zur Definition wurde die Frage aufgeworfen: Impliziert Big Data Big Security? Diese Frage ist eindeutig mit JA zu beantworten, allein aus dem Grund, da alle Informationenverarbeitende IT-Themen mit Informationssicherheit zusammenhängen. So sollte es zumindest sein. Wer heute angesichts der Vernetzung und einhergehenden Bedrohung durch Angriffe aus dem Cyberraum keine Informations-Sicherheit betreibt, handelt grob fahrlässig, das lässt sich nicht mehr anders formulieren.

Muss es deswegen gleich "BIG" sein? Nein, nicht unbedingt, "big" werden Sicherheitsthemen meist dann, wenn etwas passiert ist und keine oder nicht ausreichende Maßnahmen getroffen worden sind, um das Vorkommnis zu verhindern. Deswegen ist es ratsam sich von Beginn an auch mit dem Thema Sicherheit zu beschäftigen und die Investition in Sicherheitsmaßnahmen nicht zu scheuen. Statistisch gesehen ist eine initiale Investition in der Design-Phase nur ein Zehntel so groß wie eine Investition nach einen Vorfall im laufenden System. Wie weiß man aber welche Maßnahmen getroffen werden müssten? Auch beim Thema Big Data kommt hier das Risiko Management ins Spiel. Bei der Sammlung von großen Datenmengen sowie bei der Auswertung und Darstellung muss analysiert werden, welche Risiken mit der Verarbeitung einhergehen und wie die jeweilige Organisation mit diesen Risiken umgehen möchte. Die Grundregeln der Informationssicherheit gelten also auch für Big Data.

Neben dem risikobasiertem Ansatz bilden auch die Schutzziele Vertraulichkeit, Verfügbarkeit und Integrität die Basis der Informationssicherheit. Deswegen sollen diese drei Bereiche im Zusammenhang mit Big Data kurz skizziert werden.

Daten die im Zuge das Aufbaus einer Big Data Installation eingesammelt werden, sei es über Sensoren, Datenerhebung, Protokollierung oder jeglicher anderer Art müssen klassifiziert werden und entsprechende Maßnahmen zum Schutz der Vertraulichkeit getroffen werden. Insbesondere bei der Erhebung von Daten, die auf Personen Rückschlüsse zulassen, müssen diese auch sicher vor fremden Zugriff gespeichert und gegebenenfalls durch Verschlüsselungstechnologien geschützt werden. Je nachdem zu welchen Zwecken die Daten ausgewertet werden, sind hier auch Anonymisierungs- und Pseudonymisierungstechniken anwendbar.

Damit die auszuwertenden Daten auch den Stand widerspiegeln, der in dem jeweiligem Moment analysiert werden soll, muss die Verfügbarkeit der Daten auch zu diesem Zeitpunkt sichergestellt werden. Wenn die Daten einen nicht aktuellen Stand darstellen, besteht die Gefahr, dass falsche Rückschlüsse getroffen werden. Es muss also sichergestellt werden, dass die relevanten Daten für eine Auswertung in aktueller Ausführung verfügbar sind. Somit muss für Big Data Installationen im besonderen Maße Desaster Recovery und Business-Continuity Management betrieben und Prozesse etabliert werden, die bei Abweichungen greifen.

Auch das Schutzziel Integrität hat Auswirkung auf die Vertrauenswürdigkeit der Ergebnisse. Wenn es möglich ist die gesammelten oder die Sammlung der Daten unbemerkt zu manipulieren, sind die Ergebnisse ebenfalls der Gefahr ausgesetzt zu falschen Rückschlüssen zu führen. Deswegen sind insbesondere die Themen Zugriffsteuerung und Benutzerverwaltung zu beachten, um die Verbindlichkeit der Erhebung der Daten nachvollziehbar abbilden zu können.

Grundsätzlich sind Big Data Installationen also auch in die Sicherheits-Architektur zu integrieren und alle vorhandenen Maßnahmen gemäß der Risikoeinschätzung anzuwenden.

Doch Big Data hat noch weitere Implikationen auf Security. Denn erst durch die Möglichkeit der Analyse von großen Datenbeständen wird es auch möglich Informationen zu gewinnen, die Rückschlüsse für angepasste Sicherheitsmaßnahmen zulassen. So kann gezielter entschieden werden, welche Maßnahmen tatsächlich nötig sind, um Angriffe oder andere Aktivitäten, die die Informationssicherheit bedrohen zu verhindern oder zumindest einzuschränken. So wird es auch möglich Investition in Abwehrmechanismen genauer abzustimmen bis hin zu einer Echtzeit-Reaktion, wenn die Daten schnell genug ausgewertet werden können. Ein Bespiel für eine Big Data Auswertung ist unser Security Intelligence Report. Mit Hilfe telemetrischen Daten ist es uns möglich die Situation der Bedrohungen im Internet genauer zu bestimmen und Empfehlungen zu geben, die auf tatsächliche Bedrohungen ausgerichtet sind.

Gastbeitrag von Michael Kranawetter, Chief Security Advisor (CSA) bei Microsoft in Deutschland. In seinem eigenen Blog veröffentlicht Michael Kranawetter alles Wissenswerte rund um Schwachstellen in Microsoft-Produkten und die veröffentlichten Softwareupdates.

Die Axt im Haus erspart den Zimmermann – Open Data Nutzen selbst gemacht

Seit ein paar Jahren stellen immer mehr Verwaltungen aller Ebenen ihre Informationsschätze als Open Data ins Netz. Der große Unterschied dieser Öffnung im Gegensatz zu der erzielten, eher überschaubaren Wirkung von Informationsfreiheits- und Informationsweiterverwendungsgesetzen, besteht neben einigen anderen Aspekten darin, dass die Verwaltungen ihre Daten nun proaktiv, in Rohform und maschinenlesbar bereit stellen (eine umfassendere Beschreibung von Open Data und den Open Data Prinzipien findet sich hier).

Open Data schafft die Voraussetzung für mehr Transparenz, neue und bessere Services und häufig die Grundlage für eine konstruktive, informierte Bürgerbeteiligung. Auch in den diversen digitalen Initiativen, Agendas und Gesetzen spielt Open Data inzwischen eine zunehmende Rolle. So heißt auch im aktuellen Entwurf der Digitalen Agenda der Bundesregierung: „Durch Open Data, d. h. die maschinenlesbare Öffnung staatlicher Daten im Netz, werden wir für mehr Transparenz sorgen und neue digitale Dienste befördern."

Regierung und Verwaltungen sind nicht selber auf diese gute Idee gekommen, das jahrhundertealte „Amtsgeheimnis" in Frage zu stellen. Vielmehr wurde der Anspruch international aus der Zivilgesellschaft heraus entwickelt, seit einigen Jahren gibt es auch in Deutschland viele Initiativen und zivilgesellschaftliche Vereine, die sich engagiert dem Thema widmen. Inzwischen gibt es aber auch innerhalb der deutschen Verwaltungen, insbesondere auf der Kommunalebene – gerade dort, wo offene Verwaltungsdaten die größte Alltagsrelevanz und den engsten lokalen Bezug haben -, viele überzeugte Verantwortliche und Mitarbeiter, die diesen frischen Wind begrüßen und sich in die Suche nach den Datenschätzen stürzen. Schöne Beispiele dazu kommen aus Moers, Bremen, Bonn, Hamburg oder auch Berlin.

Die Angebote und Sammlungen von Open Data wachsen allerorten – es gibt nur einen Haken.

Die Bereitstellung von Open Data ist kein Selbstzweck. Offene Daten stiften nur dann Nutzen, wenn sie auch aufgegriffen werden, wenn sie miteinander verknüpft, analysiert und die gewonnenen Erkenntnisse verständlich visualisiert und kommuniziert werden. Das scheitert bislang in der Breite aber eben an der Natur von Open Data – es sollen möglichst unbearbeitete Rohdaten sein, die ohne Aufbereitung und Analyse kaum interpretierbar sind.

Auch wenn es inzwischen einige gute Beispiele für Anwendungen gibt, die auf offenen Daten beruhen (zum Beispiel auf Open Data Showroom), so lässt das versprochene Feuerwerk von Open Data basierten Demokratie- und Wirtschaftsimpulsen aber bislang eher noch auf sich warten. Während auf Govdata.de, dem offiziellen Datenportal für Deutschland, bislang ca. 7.200 Datensätzen zu finden sind, sieht es mit den Anwendungen, also den Open Data basierten Apps, übersichtlicher aus – Govdata.de listet hier gegenwärtig 19 Anwendungen, alleine 9 davon im Bereich von Umwelt- und Klimadaten. Neelie Kroes, Vizepräsidentin der europäischen Kommission und zuständig für die Digitale Agenda Europas, hat 2011 den möglichen jährlich wirtschaftlichen Nutzen aus Open Data mit ca. 40 Milliarden Euro beziffert. Das ist möglich – aber nur mit der Bereitstellung von Open Data sind solche Werte nicht zu realisieren.

Es ist eben bislang schwieriger, aus den offenen Daten etwas zu machen und Apps zu entwickeln, als die Open Data Prinzipien zu erklären und die Bereitstellung der Daten durch die Verwaltung zu fordern – große Halden offener Verwaltungsdaten nützen aber niemandem.

Die Erschließung und Nutzung von Open Data muss daher deutlich vereinfacht werden und nicht überwiegend davon abhängen, dass sich in bestimmten Interessenbereichen sachkundige Entwickler finden, die sich entweder aus zivilgesellschaftlichem Engagement heraus oder zur Umsetzung einer Geschäftsidee an die Entwicklung von Apps machen.

Mein Kollege Martin Ihrke zeigt in seinem aktuellen Webcast, wie man quasi mit Bordmitteln auf der Basis von Microsoft Excel in Verbindung mit den neuen Self Service Business Intelligence Ergänzungen PowerQuery, PowerPivot und PowerView, den Nutzen von Open Data ganz erstaunlich erschließen kann, auch wenn man selber kein Programmierer ist. So lassen sich in Zukunft viele Erkenntnisse aus Open Data gewinnen – übrigens auch für die Verwaltung selber-, ohne dass man erst auf die passenden Apps dafür warten muss. Mehr zu PowerBI finden Sie auch unter www.powerbi.com.

Die GAB Enterprise IT Solutions GmbH - Ein Spezialist für Cloud Productivity, Modern Workplace & individuelle Lösungen

Die GAB Enterprise IT Solutions GmbH ist ein Dienstleister und Lösungsanbieter für IT-Infrastrukturen. Als mehrfach zertifizierter Microsoft Gold-Kompetenzpartner und Microsoft CityNext Partner ist die GAB ein internationaler Spezialist für Planung, Implementierung und Migrationen von Active Directory, Mail- und Groupware Systemen sowie Lösungen zur automatisierten Softwareverteilung für Clients und Server.

Die Zielumgebungen bei Migrationsprojekten ist stets eine homogene Microsoft Umgebung. GAB ist mehrfacher Microsoft Goldpartner, einer der führenden Microsoft Cloud Partner und einer der Top Partner von Microsoft in Deutschland. Durch diese enge Verbindung mit Microsoft profitiert GAB durch sehr intensives Produktwissen. Die eigene Development Abteilung setzt auch hier an und entwickelt spezielle Migrationstools mit Microsoft Technologien.

Kundenprojekt „Wasserversorgung Bayerischer Wald"

Ein Segen für die Wasserwirtschaft: Mit mobilen Geräten zu sauberen Daten

Im November 1963 wurde wegen anhaltender Wasserknappheit im Bayerischen Wald der Zweckverband „Wasserversorgung Bayerischer Wald" gegründet. Heute versorgt Waldwasser weite Teile Ostbayerns, rund 10 Prozent der Fläche Bayerns, mit Trinkwasser. Ca. 200 Gemeinden reihen sich in die waldwasser-Gemeinschaft.

Um die gleichbleibend hohe Qualität des Trinkwassers zu sichern, sind die Wasserversorger angehalten, ihre Anlagen im festen Turnus zu kontrollieren. Die Ergebnisse ihrer Inspektionen wurden jedoch umständlich auf Excel-Listen festgehalten und dann im Büro eingegeben.

Verbesserungen

Die Bedienung von Windows 8.1 und Office 365 zusammen mit der App überzeugt. Es gibt keinen Medienbruch mehr, die Daten müssen nicht mehr extra übertragen werden. Darüber hinaus hat waldwasser mit SharePoint Online aus Office 365 das Projektmanagement standardisiert, um effektive Prozesse zu erhalten. „Mit den Windows 8.1-Tablets konnten wir den letzten Medienbruch beseitigen und zusammen mit Office 365 wird das Tablet zum kompletten Arbeitsplatz, " so der Waldwasser IT-Leiter Alfred Zehetmeier.

Weiterführende Informationen

Über den Autor

Torsten Jerschabek M.A. ist Marketingleiter Internal Operations bei GAB Enterprise IT Solutions GmbH

Die Reply Telemedizin Lösung kann im Notfall Leben retten – mehr Informationen im Rahmen unserer Veranstaltungsreihe

Die Reply Telemedizin Lösung ermöglicht die Fernüberwachung und -diagnose von Patienten oder gefährdeten Personen. Die Lösung beruht auf Standard Microsoft Komponenten wie Dynamics CRM und der IoT Suite in Verbindung mit verschiedensten Smart Devices, wie z.B. Bewegungs-, Fallsensoren oder diversen medizinischen Geräten. Mit der Reply Telemedizin Lösung wissen Ärzte, Pflegepersonal und Verwandte jederzeit über den Gesundheitszustand des Patienten Bescheid - in der Klinik, zu Hause, in der Praxis, aber auch unterwegs. Der Patient muss nicht permanent vor Ort sein um betreut, versorgt oder untersucht zu werden.

Einsatzbeispiele:

-

- Patienten können früher aus dem Krankenhaus entlassen werden; der letzte Abschnitt ihres Genesungsprozesses wird remote begleitet.

-

- Gebrechliche ältere Personen können länger im eigenen Zuhause bleiben. Eine smarte Umgebung sorgt dafür, dass im Notfall schnell Hilfe kommt – und nicht erst beim nächsten Routinebesuch des Pflegedienstes.

-

- Vitalwerte chronischer Patienten – z.B. Diabetiker – werden kontinuierlich überwacht und bei kritischer Entwicklung ein Alarm an Freunde oder Verwandte ausgelöst. Diese werden außerdem über den Aufenthaltsort des Patienten informiert.

-

- Allgemeinmediziner in abgelegenen Orten (Kreuzfahrtschiffe, Gefängnisse, Entwicklungsländer) können Patienten mit smarten Geräten wie z.B. einem EKG untersuchen und die Ergebnisse zur Diagnose an einen Experten übermitteln.

-

- Der Gesundheitszustand von Personen, die in schwer zugänglichen Bereichen oder mit gefährlichem Gerät arbeiten, kann automatisch überwacht und so die Arbeitssicherheit erhöht werden.

Wenn Sie erfahren möchten, wie Sie im Bereich Healthcare

-

- Komfort für Patienten und Angehörige verbessern können,

dann sollten Sie sich die Reply Telemedizin Lösung ansehen.

Haben wir Ihr Interesse geweckt? Mehr Informationen finden Sie hier.

Gerne möchten wir Sie auch zu unserer Veranstaltungsreihe zur Vorstellung der Lösung an verschiedenen Standorten in Deutschland einladen. Bei einem gesunden Frühstück präsentieren wir Ihnen unverbindlich unsere Lösung und stehen für einen Gedankenaustausch zur Verfügung.

Termine:

Montag, 09.11.2015 - München

Dienstag, 10.11.2015 - Frankfurt

Mittwoch, 11.11.2015 - Düsseldorf

Donnerstag, 12.11.2015 - Hamburg

Freitag, 13.11.2015 - Potsdam

Die Agenda:

8:00 – 09:00 Uhr: Ankommen & Frühstück

9:00 – 10:30 Uhr: Präsentation und Demonstration der Reply Telemedizin Lösung

ab 10:30 Uhr solange Sie wollen: Fragen & Antworten

Hier gelangen Sie zur Anmeldung.

Wir freuen uns auf Sie!

Ihr Cluster Reply, Microsoft CityNext und IoT Team

Dieses Mal im Executive Talk der eGovernment Computing das Thema "Cloud mit deutscher Datentreuhand für die Öffentliche Verwaltung"

Was bedeutet die Cloud mit deutscher Datentreuhand für die Öffentliche Hand und die öffentlichen Rechenzentren? Was sind die Sicherheitsanforderungen und wie können Siloh-Technologien durch das Zusammenspiel mit IT-Dienstleistern durchbrochen werden?

Diese und andere Fragen beantwortet Thomas Langkabel, Senior National Technology Officer Microsoft, im Executive Talk mit Herbert Klein, Chefredakteur der eGovernment Computing:

[View:https://www.egovernment-computing.de/executive-talk-mit-thomas-langkabel-v-34510-12658/:0:0]

https://www.egovernment-computing.de/executive-talk-mit-thomas-langkabel-v-34510-12658/

Happy watching,

Ihr Microsoft Public Sector Team

Drei Wege wie man eingestaubte Bürgerversammlungen wieder salonfähig macht

Bürgerversammlungen sind ein alteingesessenes Konzept, das sowohl in öffentlichen Verwaltungskreisen, als auch im Geschäftsumfeld Anwendung findet. Traditionell dienen solche Versammlungen als informelles, öffentliches Treffen, das den Mitgliedern einer Gemeinschaft die Möglichkeit gibt, aufkommende Probleme zusammen mit politischen Entscheidern zu diskutieren und Bedenken oder Präferenzen zu einem Thema zu äußern. Gleichzeitig leben wir im Zeitalter der Digitalisierung und Menschen möchten trotzdem informiert werden, auch wenn sie bei derartigen Bürgerversammlungen nicht persönlich vor Ort sind. Die Möglichkeit, immer und überall vernetzt zu sein, findet großen Anklang in der Bevölkerung. The Verbreitung von Smartphones, Tablets und Social Media hat die Erwartungen der Menschen, Informationen nach Belieben an jedem Ort sofort zur Verfügung zu haben, weiter nach oben geschraubt. Viele Kommunalverwaltungen haben Mühe mit modernen Technologien, die heute für die meisten von uns selbstverständlich sind, Schritt zu halten. Öffentliche Verwaltungsangestellte sehen sich mit der Aufgabe konfrontiert, Informationen unterschiedlicher Art an zentraler Stelle zu bündeln, zu filtern und zeitnah zu bearbeiten, um schließlich den Bedürfnissen der Bürger gerecht zu werden. Wie wäre es, wenn man eine Brücke zwischen all diesen verschiedenen Medien schlagen und eine einfache Vernetzung und schnelle Kommunikation mit allen Bürgern ermöglichen könnte, egal wo sich diese gerade aufhalten? Unterstützt durch Microsoft und AvePoint beschreitet die Stadt Newton, nur 11 km westlich von Boston gelegen, neue Wege in Sachen Bürgerdialog und integriert neue Technologien in die ursprünglichste Form von Interaktion zwischen Stadt und Bürger – der Bürgerversammlung. Durch den gemeinsamen Einsatz von Microsoft Cloud-Technologien wie Microsoft Azure, Office 365, Parature (2014 von Microsoft übernommener Kundendienst-SaaS-Anbieter) und AvePoint Podium modernisiert die Stadt ihre Bürgerversammlung: - Die Stimmung unter den Bürgern verstehen: Die Stadt Newton konnte bereits vor und während einzelner Versammlungen Fragen und Feedback einsammeln, unabhängig davon, ob die Personen persönlich anwesend oder über das öffentlich zugängliche Rathaus-Portal verbunden waren.

- Die Bedürfnisse der Bürger kennen: Der Bürgermeister und sein Team konnten bereits vor und während einzelner Sitzungen Fragen sichten und bewerten, um Informationen gezielter zur Verfügung stellen zu können.

- Die Interaktion mit dem Bürger verbessern: Für alle, die an den Sitzungen nicht persönlich teilnehmen konnten, stellte AvePoint Podium ein öffentlich zugängliches Rathaus-Portal zur Verfügung. Bürger konnten so der Versammlungen live beiwohnen, Fragen stellen und Diskussionen in Echtzeit verfolgen, sowie Aufnahmen vergangener Sitzungen ansehen.

Das Beispiel der Stadt Newton zeigt, wie einfach es mit AvePoint Podium ist, mehr Bürger zu erreichen, sie zu mehr politischem Engagement zu bewegen und so politische Abläufe transparent zu gestalten. Auch für Behörden und Verwaltungen auf nationaler, lokaler oder Landesebene in Deutschland liefert Newton ein Paradebeispiel dafür, wie der Einsatz moderner Technologien moderne, bürgernahe und lebenswerte Städte schafft. Weitere Informationen zu AvePoint Podium, finden Sie auf der AvePoint-Webseite. |

Über den Autor:

Christopher Musico, Vice President of Global Communications, AvePoint Inc.

In seiner Rolle als Vice President of Global Communications steuert Christopher Musico die Planung und Umsetzung der globalen Kommunikationsstrategie des Unternehmens, darunter Analyst Relations, Customer Evidence, internationale Kommunikation, Public Relations und Social Media. Vor seiner Tätigkeit bei AvePoint, war er beim CRM Magazine für den Themenbereich Kollaborationstechnologien zuständig und gewann für seine Sonderbeiträge zum Thema Cloud Computing und Megatrends zahlreiche Auszeichnungen. Sein Bachelorstudium der Kommunikationswissenschaften an der Seton Hall University schloss er summa cumlaude ab. |

E-Government-Kooperation zwischen EITCO und Microsoft: Die moderne E-Government-Lösung für die Länder und Kommunen, um Landesgesetze und kommunale Bekanntmachungen sicher und einfach zu veröffentlichen

Der Microsoft Partner EITCO hat einen neuen Lösungsvorschlag zum Thema „Gesetzesentstehungs- und Veröffentlichungsprozess bis zum Amtsblatt" auf der Grundlage des eGovernment-Gesetzes entwickelt. Die Umsetzungsempfehlung basiert auf den Microsoft Produkten BizTalk Server, SharePoint Server und SQL-Server. Das Konzept wird auf der CeBIT in der Public Sector Halle 7 vorgestellt und mit einer Demonstrator veranschaulicht.

EITCO und Microsoft geben mit Ihrer Zusammenarbeit ein Beispiel, wie gemeinsam modernes E-Government gestaltet werden kann. Für die neu entwickelte Lösung "Elektronisches Amtsblatt" in Bund und Ländern setzt die European IT Consultancy EITCO GmbH insbesondere auf eine enge Zusammenarbeit mit Microsoft. Damit kommen die Anwendungssplattform Microsoft SharePoint Server und die Integrationslösung Microsoft BizTalk Server zur Automatisierung des Prozesses zum Einsatz. EITCO und Microsoft versprechen sich viel von dieser Zusammenarbeit, um auch in Zukunft modernste Lösungen für E-Government und die öffentlichen Verwaltungen insgesamt bereitzuhalten.

Ein Schritt auf dem Weg zur Überprüfung der Rechtsprechung zu Durchsuchungsbeschlüssen

Ende April hat US Magistratsrichter James Francis eine Anfechtungsklage von Microsoft gegen einen seiner Durchsuchungsbefehle vom Dezember letzten Jahres zurückgewiesen, der sich auf im Ausland gespeicherte Daten bezieht.

In diesem Blog-Beitrag nimmt David Howard, Corporate Vice President & Deputy General Council von Microsoft, dazu Stellung und beschreibt die nächsten Schritte (Übersetzung des englischen Original Blog-Beitrags vom 26. April 2014).

______________________

Die US-amerikanische Regierung verfügt nicht über die Befugnis, eine Hausdurchsuchung in einem anderen Land durchzuführen. Sie sollte auch nicht die Befugnis haben, die Inhalte von Emails, die nicht in den USA gespeichert werden, zu durchsuchen.

Um diesen Grundsatz zu bewahren, haben wir bereits vor Monaten eine förmliche Anfechtungsklage („legal challenge") gegen einen US-amerikanischen Durchsuchungsbeschluss („search warrant") eingereicht, der sich auf den Inhalt einer Email eines Kunden von uns bezog, der ausschließlich außerhalb der USA gespeichert wurde. Heute haben wir eine Erstentscheidung in dieser Sache erhalten, die den Status Quo zunächst aufrechterhält, für uns aber ein notwendiger Schritt bei unserer Bemühung ist, sicherzustellen, dass sich die Regierungen an Recht und Gesetz halten, wenn sie uns künftig um die Herausgabe von privaten Daten unserer Kunden ersuchen.

Bei Einreichung der Anfechtungsklage war klar, dass der Rechtsweg zunächst bei einem Magistratsrichter („magistrate jugde") beginnen wird und dass wir erst später höchstwahrscheinlich die Möglichkeit haben werden, den Fall vor einem US-amerikanischen Distriktrichter („district court judge") und voraussichtlich auch vor einem US-amerikanischen Berufungsgericht („federal court of appeals") zu verhandeln. Heute hat der Magistratsrichter, der den besagten Durchsuchungsbeschluss ursprünglich angeordnet hatte, unserer Ansicht widersprochen und unsere Anfechtungsklage abgewiesen. Damit ist der erste Schritt vollzogen, um die Angelegenheit vor die Gerichte zu bringen, die dazu befugt sind, die langjährige Ansicht der US-amerikanischen Regierung zur Anwendbarkeit von Durchsuchungsbeschlüssen, bei denen es um außerhalb der USA digital gespeicherte Inhalte geht, zu berichtigen.

Obwohl die Gesetzeslage kompliziert ist, ist die Sache an sich einfach. Es ist allgemein anerkannt, dass ein US-amerikanischer Durchsuchungsbeschluss in der physischen Welt nur zur Erlangung von Gütern genutzt werden kann, die sich im Hoheitsgebiet der USA befinden. So kann ein US-amerikanischer Staatsanwalt keinen US-amerikanischen Durchsuchungsbeschluss erwirken, um damit eine Hausdurchsuchung in einem anderen Land durchzuführen. Genauso wenig kann ein Staatsanwalt eines anderen Landes in seinem eigenen Land einen Durchsuchungsbeschluss erwirken, um eine Durchsuchung in den USA durchzuführen. Aus diesem Grund haben die USA eine Vielzahl von bilateralen Vereinbarungen abgeschlossen, die besondere Verfahrensweisen für die Beweiserhebung in einem anderen Land regeln. Wir sind der Auffassung, dass dieselben Vorschriften auch auf die Online-Welt angewandt werden sollten - die amerikanische Regierung teilt diese Auffassung allerdings nicht.

Wir möchten eindeutig hervorheben, dass wir die wichtige Rolle, die die Strafverfolgung für den Schutz von uns allen hat, anerkennen. Wir versuchen nicht, die Ermittlungen der Regierung zu behindern und sind der Meinung, dass diese in der Lage sein sollte, die erforderlichen Beweise zu erlangen, um gegen mögliche Straftaten zu ermitteln. Wir sind lediglich der Auffassung, dass die Regierung verpflichtet sein sollte, die von ihr selbst eingeführten Verfahren für den Erhalt von physischen Beweismaterial außerhalb der USA zu befolgen.

Die Initiierung derartiger gerichtlicher Überprüfungen ist eines der Datenschutz-Commitments, die wir im Dezember veröffentlicht haben. Wir werden dieses Thema weiterverfolgen, da wir der Meinung sind, dass wir die Gesetzeslage richtig auslegen, und uns unsere Kunden zudem mitteilen, dass sie mit unseren Datenschutz-Commitments sehr zufrieden sind.

David Howard

Corporate Vice President & Deputy General Counsel, Microsoft

Einladung zum Microsoft Healthcare Partnertag am 15. Januar in Berlin

Unter dem Motto „GESUNDHEIT STÄRKEN schon heute für ein gesünderes Morgen!" und vor dem aktuellen Hintergrund der Microsoft Cloud-Strategie für Deutschland findet am 15. Januar 2016 ein Healthcare Partnertag in Berlin statt.

Erfahren Sie dort aus erster Hand mehr über das flexible Microsoft Cloud-Angebot und diskutieren Sie mit Experten dessen Bedeutung für die Gesundheitswirtschaft!

Microsoft Healthcare Partner - wie beispielsweise der Microsoft CityNext-Partner Cluster Reply mit der Lösung Remote Monitoring - geben Einblicke in ihren Weg in die Cloud und bereits umgesetzte Projekte, die Sie für Ihre eigene Cloud-Strategie nutzen können.

Lernen Sie moderne Technologien wie Hololens, Surface Hub, das Microsoft Health Band und Medical Tablets kennen. Erfahren Sie, wie diese Devices jetzt schon genutzt werden und wo sie in Zukunft eingesetzt werden können.

Im Anschluss haben Sie Gelegenheit, Kontakte zu anderen Partnerunternehmen und zum Microsoft Team zu knüpfen und sich über die Themen auszutauschen.

Freuen Sie sich über folgende Highlights:

Microsoft-Investition in die Cloud – Bedeutung für Innovation im Gesundheitswesen

Cloud Services – der datenschutzrechtliche Rahmen

Partner Impulsvorträge zu bereits realisierten Cloud-Lösungen, neuen Wegen und Geschäftsmodellen

Neue Devices – Hololens, Surface Hub, Health Band, Medical Tablets

Microsoft CityNext – Info booth

Melden Sie sich noch heute kostenlos hier an.

Wir freuen uns auf Ihre Teilnahme,

Ihr Microsoft CityNext-Team

Einladung zum Microsoft Polizeiforum 2016

Diesen Termin sollten Sie sich schon jetzt in Ihrem Kalender freihalten:

Am 19. Januar 2016 findet in Berlin das Microsoft Polizeiforum 2016 statt. Unter dem Motto „Neue Technologien und Geräte für die moderne Polizeiarbeit" demonstrieren namhafte Referenten von Microsoft, Partnern und seitens der Polizei, wie Sie von den neuesten Entwicklungen praktisch profitieren können.

Besondere Aufmerksamkeit wird dabei auch auf die neue „Microsoft Cloud für Deutschland" gelegt, die Microsoft-CEO Satya Nadella vor kurzem in Berlin vorgestellt hat. Der Einsatz eines deutschen Datentreuhänders erlaubt es nun auch der Polizei, rechtskonforme Cloud-Dienste zu nutzen. Das ergibt gerade für die mobile Polizeiarbeit eine Fülle neuer Möglichkeiten.

Folgende Inhalte erwarten Sie bei der Veranstaltung:

Moderne Polizeiarbeit am Beispiel einer großen Polizei in einem Flächenland

Was bedeutet die „Microsoft Cloud für Deutschland" konkret für die Polizei?

Wie kann die Nutzung von Office 365 die mobile Polizeiarbeit beschleunigen?

Erfahrungsbericht einer Polizei mit Lösungen für den mobilen Polizeieinsatz

Erfahrungsbericht einer Polizei mit einer modernen Lösung für polizeiliche Prognosen und Vorhersagen

- Beispiele moderner Polizeilösungen im weltweiten Vergleich

Darüber hinaus:

Erleben Sie neue Geräte, angefangen vom aktuellen Windows Phone Lumia 950 bis hin zum Surface Hub

Q&A sowie Raum für Diskussionen

Weitere Informationen und Anmeldung

Wir freuen uns darauf, diese und weitere Themen mit Ihnen zu diskutieren!

Ihr Microsoft Public Sector Team

Erleben Sie mit Microsoft das Digitale Wirtschaftswunder auf der CeBIT 2016!

Auf der CeBIT 2016 präsentiert Microsoft sieben Faktoren für den Wandel, die den Weg ins Digitale Wirtschaftswunder weisen. Microsoft zeigt gemeinsam mit „Wirtschaftswundermachern" an konkreten Projekten, wie sich Infrastruktur, Organisation, Team, Mitarbeiter, Wissen, Produktion und Staat optimal aufstellen, um die digitale Transformation zu meistern.

Produktive Lösungen aus der sicheren Cloud und smarte Devices tragen dazu bei, die Leistungsfähigkeit und Innovationskraft am Standort Deutschland weiter zu stärken.

Dabei schaffen Technologien aus der Cloud neuen Gestaltungsspielraum: Werkzeuge für Zusammenarbeit und soziale Netzwerke mobilisieren Mitarbeiter, Teams und Wissen unabhängig von Endgeräten und Abteilungsgrenzen. Und mit Lösungen aus der Microsoft Cloud Deutschland muss die öffentliche Hand ihre Souveränität nicht aufgeben.

So zeigt unser Microsoft CityNext Partner [ui!] Urban Software Institute GmbH, wie aus der Microsoft Cloud Deutschland über [ui!] UrbanPulse mit [ui!] COCKPIT verschiedene Anwendungsfälle, wie zum Beispiel intelligente Verkehrsführung, Smart Lighting oder das Management von Elektrofahrzeug-Flotten für eine Smart City realisiert werden können.

Darüber hinaus zeigen weitere Partner innovative Lösungen aus den Bereichen

Reinvent Productivity and Business Processes.

Build the intelligent cloud platform.

Create more personal computing.

Überzeugen Sie sich vom 14. bis 18. März in Hannover, wie die öffentliche Verwaltung das digitale Wirtschaftswunder prominent fördern und gleichzeitig selbst daran partizipieren kann. Weitere Informationen finden Sie auf der Microsoft CeBIT Website: https://www.microsoft.com/de-de/cebit/default.aspx

Jetzt kostenfrei zum Partnerevent anmelden: Die neue Microsoft Cloud mit deutscher Datentreuhand – Neue Chancen für Lösungspartner der öffentlichen Verwaltung

Erst vor kurzem hat Microsoft-CEO Satya Nadella die neue Microsoft Cloud mit deutscher Datentreuhand angekündigt. Sie steht für die Bereitstellung der Microsoft-Dienste Azure, Office 365 sowie Dynamics CRM Online über eigenständige deutsche Rechenzentren in Frankfurt und Magdeburg. Dabei handelt es sich um ein am Markt einzigartiges Microsoft Cloud-Modell. Zukünftig können Sie sich für die Entwicklung, Bereitstellung und den Vertrieb im Rahmen Ihres Lösungsgeschäfts für eine neue Cloud entscheiden und von neuen Geschäftsmöglichkeiten profitieren.

Wir laden Sie hiermit herzlich ein dieses neue Microsoft Cloud-Angebot und die für Sie als Lösungsanbieter damit verbundenen Geschäftsmöglichkeiten am 15. Dezember 2015 in Berlin kennen zu lernen und gemeinsam mit Experten die Bedeutung für die öffentliche Verwaltung zu diskutieren.

Folgende Inhalte erwarten Sie bei der Veranstaltung:

Das Konzept Microsoft Cloud mit deutscher Datentreuhand

Die Umsetzung des Konzeptes und der zeitliche Plan für die Einführung

Die konkreten Angebote der Microsoft Cloud für Ihre Partnerlösungen

Erfahrungsberichte der Microsoft CityNext Partner hubermedia, TELEPORT und CODE3/Fireplan über den Einsatz ihrer Cloud-Lösungen bei Kunden

Ihr Geschäft in der Microsoft-Cloud – neue Geschäftsmodelle und Chancen für Partner in einem "Cloud-First, Mobile-First"-Markt

Q&A

Die Verknüpfung der Innovationskraft und Skalierbarkeit unserer Microsoft Cloud-Plattform mit deutscher Infrastruktur und deutschem Datentreuhänder ist aus unserer Sicht am Markt einzigartig – nutzen auch Sie diese Chance für Weiterentwicklung und Wachstum Ihres Lösungsgeschäfts. Lassen Sie uns gemäß dem Motto der Deutschen Partnerkonferenz ZUSAMMEN.WACHSEN und die digitale Verwaltung für und mit unseren Kunden gemeinsam gestalten.

Bis zur Veranstaltung am 15. Dezember 2015finden Sie aktuelle Informationen auf der offiziellen Website, in einem kurzen Einführungs-Video auf YouTube, auf unserem MPN Blog oder in einem Webcast am Montag, den 30. November 2015 von 10 bis 11 Uhr, der sich speziell an Partner richtet.

Hier geht es zur Anmeldung

Wir freuen uns auf Ihre Teilnahme!

Ihr Microsoft Public Sector und Microsoft CityNext-Team

Leben, lernen und lenken in der vernetzten Stadt – das Motto der diesjährigen Major Cities of Europe Conference in Hamburg

Die Freie und Hansestadt Hamburg ist in diesem Jahr Ausrichterin der unter dem Motto „cITy 2020: Living, learning, leading in the connected city" stehenden Major Cities of Europe Conference 2015 (https://www.majorcities.eu/conferences/2015-hamburg/), der Netzwerkplattform europäischer Städte zu IT und E-Government Themen, die vom 8. bis 10. Juni in Hamburg stattfinden wird.

„Major Cities of Europe" ist eine Non-Profit Organisation für CIOs und Manager, die den Austausch von Strategien, Erfahrungen und Lösungen für Mittel- und Großstädte im IT-Bereich organisiert. Ziel ist es, im Netzwerk der Metropolen Wissen zu teilen und voneinander zu lernen.

Im Rahmen der diesjährigen Konferenz wird Microsoft CityNext (www.microsoft.de/citynext) , die weltweite Initiative, die gemeinsam mit Microsoft Partnern die digitale Transformation in urbanen Räumen vorantreiben möchte, über den gesamten Zeitraum im Ausstellerbereich mit einem Stand präsent sein. Hier werden IT-Lösungen von Microsoft CityNext Partnern wie beispielsweise MeineKITA (Akquinet), opendoors (Zebralog), Cityscope (bluehands) der auch das Service-Desk-Tool Lernwelt & Autopilot (soluzione) gezeigt. Dabei decken die Microsoft CityNext Partnerlösungen die vier Bereiche Bildung, Öffentliche Sicherheit und Justiz, Gesundheit und Modernisierung der Stadtverwaltung der Initiative ab.

Microsoft CityNext wird darüber hinaus einen Workshop zu dem Thema „More than Smart – What it Takes to Shape a Resilient City" am 08. Juni von 17:00-17:40 Uhr im 3. Stock der Workshop Area durchführen. Rüdiger Dorn, Director Technology Strategy Europe, Middle East and Africa, wird den Fokus seines Vortrags auf das Thema „Innovation and Trust" legen und gerne mit Ihnen diskutieren, wie mittels innovativer und sicherer Lösungen die Stadt von morgen aussehen könnte.

Ein weiteres Highlight im Kontext Microsoft CityNext wird das Testimonial der Stadt Breda sein. Am Nachmittag des ersten Konferenztages wird Mark Voermans (Ireckon BV) darüber berichten, wie die niederländische Stadt Breda Überflutungen durch den Einsatz des Abwasser Management Projekts „Waterakkers" (https://www.youtube.com/user/majorcitiesofeurope), einer Microsoft Azure Cloud Lösung, in den Griff bekommt und dabei Kosten reduzieren kann.

Weitere Informationen zu der Anmeldung finden Sie hier: https://www.amiando.com/mce2015.html

Wir freuen uns auf Ihren Besuch und ein persönliches Kennenlernen auf der bevorstehenden Konferenz!

Ihr Microsoft CityNext Team

https://www.youtube.com/watch?v=PmIvmz1hJuQ

mediDOK® setzt bei seiner mobilen Lösung „mediDOK® mobile" voll auf Microsoft Technologien und liefert dieses neue Modul exklusiv für Endgeräte unter Windows 8 bzw. Windows RT

Die mediDOK® Software Entwicklungs GmbH stellt auf Europas größter und bedeutendsten Messe für Healthcare IT, der conhIT, ihre neue Software „mediDOK® mobile"

das erste Mal der breiten Öffentlichkeit vor. Sie finden mediDOK® in Halle 1.2, Stand B-104 sowie auf dem Stand der medatixx GmbH & Co. KG in Halle 1.2, Stand A-103. Die conhIT findet vom 9. bis 11. April 2013 in

Berlin auf dem Messegelände, Messedamm 22, statt.

Mit mediDOK® mobile können Anwender von unterwegs oder innerhalb der Praxis auf alle bereits im mediDOK®-System gespeicherten Patienten zugreifen und deren Bilder und Dokumente mit einem mobilen Endgerät aufrufen und betrachten. Die Datenübertragung setzt eine gesicherte Internetverbindung zum mediDOK®-Server des Kunden voraus. Und im Falle von Hausbesuchen, bei denen absehbar keine Internetverbindung zur Verfügung stehen wird, können die Anwender bereits vorher innerhalb der Praxis bestimmen, welche Patienten, Bilder und Dokumente auf dem mobilen Endgerät verfügbar sein sollen. Diese können dann vor Ort „offline" aufgerufen und betrachtet werden.

mediDOK ® setzt sich mit Microsoft neue Ziele

mediDOK® mobile wurde speziell für das Microsoft Surface entwickelt und designed. „Wir gehen davon aus, dass sich Windows 8 bzw. Windows RT bei unseren Kunden sehr schnell verbreiten wird. Die mobilen Geräte von Microsoft - insbesondere das Surface - lassen sich zudem sehr einfach in die bestehende Netzwerk- und Rechnerinfrastruktur einbinden. Und mediDOK® bietet mit mediDOK® mobile die passende App dafür." sagt Wolfgang Wesch, in der Geschäftsführung zuständig für Entwicklung und Technologien.

„Die mediDOK® mobile App ist ein ausgezeichnetes Beispiel, wie niedergelassene Ärzte, Medizinische Versorgungszentren oder Ambulanzen von der neusten Microsoft Technologie

profitieren." erläutert Christian Köth, Leiter Healthcare Microsoft Deutschland GmbH. Microsoft engagiert sich seit über 15 Jahren weltweit in der Gesundheitswirtschaft. „Ein wesentlicher Erfolgsfaktor ist dabei die Zusammenarbeit mit innovativen Partnern wie die mediDOK® Software Entwicklungs GmbH."

Ab Ende des 2. Quartals 2013 auch für alle anderen mediDOK Anwender verfügbarFür die Anwender des mediDOK® 2.0 Bild- und Dokumentenarchivs steht mediDOK® mobile voraussichtlich ab Ende des 2. Quartals 2013 zur Verfügung.

Medienberichte über US-Sicherheitsprogramm

Am 16. Juli veröffentlichte Brad Smith, General Counsel & Executive Vice President Legal & Corporate Affairs von Microsoft, in einem Beitrag des Firmen-Blogs seine Stellungnahme auf jüngste Berichte über Microsoft, die auf in die Öffentlichkeit gelangten Regierungsdokumente basieren. Bezüglich dieser Dokumente gibt es erhebliche Fehlinterpretationen, worauf Brad Smith in seinem Blogpost eingeht. Er stellt auch nochmals klar, nach welchen hohen Grundsätzen das Unternehmen Behördenanordnungen nachkommt.

Lesen Sie im Folgenden eine deutsche Übersetzung des Beitrags von Brad Smith:

**********

Reaktion auf gesetzlich begründete Anfragen der Regierung für die Bereitstellung von Kundendaten

Von Brad Smith General Counsel & Executive Vice President, Legal & Corporate Affairs, Microsoft

Wir haben heute den amerikanischen Justizminister gebeten, persönlich Maßnahmen zu ergreifen, die es Microsoft und anderen Unternehmen gestatten, umfassendere Informationen darüber zu veröffentlichen, wie wir mit nationalen Sicherheitsanfragen für die Bereitstellung von Kundendaten verfahren. Obwohl wir der Auffassung sind, dass uns die amerikanische Verfassung das Recht einräumt, weitere diesbezügliche Informationen zu veröffentlichen, hindert uns die Regierung daran. So steht beispielsweise eine Antwort der Juristen der Regierung auf einen Antrag aus, den wir am 19. Juni bei Gericht eingereicht haben und in dem wir um die Erlaubnis zur Veröffentlichung der nationalen Sicherheitsanfragen, die an uns herangetragen wurden, in vollem Umfang ersuchen. Wir hoffen, dass der Justizminister in diesem Zusammenhang eingreifen kann, um die Situation zu verändern.

Bis dahin ist es unser Anliegen, so viele Informationen zu veröffentlichen, wie wir derzeit dazu in der Lage sind. Es liegen erhebliche Ungenauigkeiten in den Auslegungen der geheimen Regierungsdokumente vor, die den Medien zugespielt und über die vergangene Woche in den Medien berichtet wurde. Wir haben die Regierung erneut um die Erlaubnis gebeten, die Fragen, die sich durch diese neuen Dokumente ergeben haben, zu erörtern, aber unser Antrag wurde von den Juristen der Regierung abgelehnt. Einstweilen haben wir als Reaktion auf die Vorwürfe in der Berichterstattung die Informationen zusammengefasst, die wir veröffentlichen dürfen:

- Outlook.com (früher Hotmail): Wir gewähren keiner Regierung den direkten Zugriff auf Emails oder Sofortnachrichten. Punkt. Wie alle Anbieter von Kommunikationsdiensten sind wir bisweilen verpflichtet, gesetzlich begründeten Anfragen von Regierungen nachzukommen und Inhalte für bestimmte Konten (Accounts) bereitzustellen, um damit einem Durchsuchungsbeschluss oder einer gerichtlichen Verfügung zu entsprechen. Diese Vorgehensweise gilt in den USA sowie in anderen Ländern, in denen wir Daten speichern. Nach Erhalt einer derartigen Anfrage findet eine Überprüfung statt; wenn wir dazu verpflichtet sind, kommen wir dieser Anfrage nach. Wir stellen keiner Regierung technische Möglichkeiten zur Verfügung, mit denen sie direkt oder selbst auf die Inhalte der Nutzer zugreifen. Stattdessen müssen Regierungen weiterhin rechtsgültigen Verfahren folgen, um bestimmte Informationen über identifizierte Konten (Accounts) von uns zu erhalten.

- Nicht überraschen dürfte die Tatsache, dass wir diesen gesetzlichen Verpflichtungen auch unterliegen, wenn wir unsere Produkte aktualisieren und sogar dann, wenn wir Verschlüsselungs- und Sicherheitsmaßnahmen verstärken, um den Schutz der Inhalte während der Übertragung im Internet zu verbessern. Die kürzlich den Medien zugespielten geheimen Regierungsdokumente konzentrieren sich auf die zusätzliche HTTPS-Verschlüsselung der Sofortnachrichten auf Outlook.com, mit der diese Inhalte sicherer im Internet übertragen werden. Es muss klar festgehalten werden, dass wir keiner Regierung eine Möglichkeit einräumen, Verschlüsselungsmaßnahmen zu umgehen; zudem stellen wir keiner Regierung Verschlüsselungscodes zur Verfügung. Wenn wir gesetzlich dazu verpflichtet sind, Anfragen nachzukommen, nehmen wir die spezifischen Inhalte unverschlüsselt von unseren Servern, auf denen sie gespeichert wurden, und stellen diese Inhalte anschließend der Regierung zur Verfügung.

- Durchforstet man alle technischen Details, ergeben sich für alle Informationen aus den geheimen Regierungsdokumenten, die den Medien zugespielt wurden, zwei Tatsachen. Erstens: Während wir tatsächlich, wie in der vergangenen Woche berichtet wurde, die Einhaltung der gesetzlich begründete Anfragen mit der Regierung erörtert haben, stellte Microsoft weder in einer Besprechung einer Regierung den direkten Zugang zu Inhalten der Nutzer zur Verfügung, noch hat sich Microsoft bereit erklärt, dies zu tun; ferner stellte Microsoft auch keine Möglichkeit zur Verfügung, mit der unser Verschlüsselungssystem ausgehebelt werden könnte. Zweitens ging es bei den Besprechungen um das Thema, wie Microsoft seine kontinuierliche Verpflichtung zur Erfüllung der gesetzlichen Vorschriften durch Bereitstellung von bestimmten Informationen aufgrund einer rechtmäßigen Verfügung der Regierung erfüllt.

- SkyDrive: Auf die gleiche Weise reagieren wir auf gesetzlich begründete Anfragen der Regierung hinsichtlich der in SkyDrive gespeicherten Daten. Alle Anbieter von Speicherdiensten dieser Art sind gesetzlich dazu verpflichtet, die gespeicherten Inhalte zur Verfügung zu stellen, wenn sie ordnungsgemäß und von Rechts wegen dazu aufgefordert werden. 2013 veränderten wir unsere Prozesse, um auch weiterhin der zunehmenden Anzahl von gesetzlich begründeten Anfragen von Regierungen weltweit nachzukommen. Dabei wurde keine Änderung durchgeführt, die einer Regierung den direkten Zugang zu SkyDrive ermöglichen würden. Auch wurde nichts an der Tatsache geändert, dass Regierungen nach wie vor rechtsgültige Verfahren einhalten müssen, um Kundendaten anzufordern. Das Verfahren zur Erzeugung von auf SkyDrive gespeicherten Daten ist dasselbe, unabhängig davon, ob es sich um einen Durchsuchungsbeschluss in Verbindung mit einer Straftat handelt oder um eine Reaktion auf einen nationalen Sicherheitsbeschluss in den USA oder in einem anderen Land.

- Anrufe über Skype: Wie bei den anderen Diensten reagieren wir auch hier lediglich auf die gesetzlich begründeten Anfragen der Regierungen und entsprechen lediglich den Anfragen für bestimmte Konten (Accounts) oder Kennungen (Identifiers). Die Berichterstattung der vergangenen Woche enthielt Vorwürfe über eine bestimmte Änderung, die 2012 vollzogen worden sei. Wir verbessern und entwickeln das Angebot rund um Skype kontinuierlich und haben auch diverse Verbesserungen des technischen Backends von Skype eingeführt, beispielsweise das seit 2012 intern durchgeführte Hosting der „Superknoten" sowie die Migration zahlreicher Sofortnachrichten, die über Skype laufen, auf die Server in unseren Datenzentren. Diese Veränderungen erfolgten nicht, um den Zugang von Regierungen auf Audio-, Video-, Messaging- oder andere Kundendaten zu vereinfachen. Aber aufgrund der zunehmenden Nutzung von internetbasierter Sprach- und Videokommunikation ist klar, dass Regierungen künftig ein Interesse an der Nutzung (beziehungsweise Schaffung) von gesetzlichen Befugnissen haben werden, um den Zugang auf diese Art von Inhalten zu sichern und um bei Verdacht auf kriminelle Handlungen Ermittlungen durchzuführen oder den Terrorismus zu bekämpfen. Wir gehen daher davon aus, dass alle Anrufe, ob sie über das Internet, im Festnetz oder auf dem Mobiltelefon erfolgen, ähnliche Datenschutz- und Datensicherheitsstufen aufweisen werden. Selbst unter diesen Umständen ist Microsoft auch weiterhin daran gelegen, nur gesetzlich begründeten Anfragen hinsichtlich der Informationen über bestimmte Nutzerkonten nachzukommen. Wir werden keiner Regierung den direkten oder uneingeschränkten Zugang zu Kundendaten oder Verschlüsselungscodes gewähren.

- Speichern von Emails und Dokumenten im Unternehmen: Sollten wir eine Anfrage zur Bereitstellung von Daten eines Unternehmenskunden von einer Regierung erhalten, ergreifen wir Maßnahmen, um die Regierung direkt an den Kunden zu verweisen und benachrichtigen den Kunden, es sei denn, dies ist uns rechtlich untersagt. Wir haben zu keinem Zeitpunkt einer Regierung Kundendaten von einem unserer Unternehmenskunden oder einem Kunden aus dem öffentlichen Sektor für nationale Sicherheitszwecke zur Verfügung gestellt. In Bezug auf Anfragen in Zusammenhang mit einer Strafverfolgung haben wir in unserem Bericht über Anfragen in Zusammenhang mit einer Strafverfolgung (Law Enforcement Requests Report) deutlich gemacht, dass wir im gesamten Verlauf des Jahres 2012 lediglich vier Anfragen nachgekommen sind, die in Zusammenhang mit Unternehmenskunden oder Kunden des öffentlichen Sektors standen. In drei Fällen unterrichteten wir die Kunden über die Anfrage; diese Kunden baten uns, die Daten zu erstellen. Im vierten Fall erhielt der Kunde die Anfrage direkt und beauftragte Microsoft mit der Erzeugung der Daten. Wir stellen keiner Regierung Möglichkeiten zur Verfügung, mit denen sie die Verschlüsselungsmaßnahmen umgehen, die angewandt werden, um unsere Unternehmenskunden und deren Daten in der Cloud zu schützen; und wir stellen zudem keiner Regierung Verschlüsselungscodes bereit.

Zusammenfassend ist festzustellen, dass wir uns bemühen, prinzipientreu zu agieren, nur in begrenztem Umfang Daten offenzulegen und transparent zu sein, wenn Regierungen Informationen von Microsoft über Kunden anfordern. Insgesamt ergeben sich aus diesen Grundsätzen folgende Fakten für unser komplettes Software- und Services-Angebot:

- Microsoft ermöglicht keiner Regierung den direkten und uneingeschränkten Zugang zu Kundendaten. Microsoft nimmt diese Daten lediglich (von seinen Servern) und stellt anschließend die spezifischen Daten bereit, die im Rahmen der relevanten gesetzlich begründeten Anfrage offengelegt werden müssen.

- Falls eine Regierung Kundendaten anfordert – auch für Zwecke der nationalen Sicherheit –, muss diese Regierung die anwendbaren rechtsgültigen Verfahren befolgen, das heißt, sie muss uns eine gerichtliche Verfügung für die Bereitstellung der Inhalte oder eine gerichtliche Vorladung für die Bereitstellung der Kontoinformationen (Account Information) vorlegen.

- Wir beantworten lediglich Anfragen zu spezifischen Konten (Accounts) und Kennungen (Identifiers). Es gibt weder eine Pauschalgenehmigung noch einen wahllosen Zugang zu Kundendaten von Microsoft. Die gesammelten Daten, die wir veröffentlichen konnten, zeigen deutlich, dass lediglich ein winziger Bruchteil – das heißt Bruchteile eines Prozents – unserer Kunden von einer Anfrage einer Regierung in Zusammenhang mit strafrechtlichen Maßnahmen oder der nationalen Sicherheit betroffen war.

- Alle Anfragen werden von dem Compliance Team bei Microsoft sehr genau überprüft, das sicherstellt, dass die Anfrage rechtsgültig ist beziehungsweise Anfragen, die nicht rechtsgültig sind, ablehnt und zudem gewährleistet, dass wir lediglich die Daten bereitstellen, die Gegenstand der Verfügung sind. Während wir verpflichtet sind, die Vorschriften einzuhalten, handhaben wir weiterhin das Verfahren zur Einhaltung der Vorschriften, indem wir den Verfügungen, die wir erhalten, entsprechen sowie sicherstellen, dass diese rechtsgültig sind und indem wir zudem nur die Daten offenlegen, die Gegenstand der Verfügung sind.

Microsoft ist verpflichtet, die geltenden Gesetze einzuhalten, die Regierungen weltweit – und nicht nur in den USA – verabschieden; dazu gehört die Reaktion auf gesetzlich begründete Anfragen für die Bereitstellung von Kundendaten. Wir alle leben heute in einer Welt, in der Unternehmen und Regierungsbehörden große Datenmengen (Big Data) nutzen und daher ist es falsch anzunehmen, diese Tatsache sei auf die USA beschränkt. Sehr wahrscheinlich erhalten Behörden diese Informationen aus einer Vielzahl von Quellen und über viele unterschiedliche Wege. Um Kundendaten von Microsoft zu erhalten, müssen sie aber rechtsgültige Verfahren einhalten.

Weltweit ist eine offenere und öffentliche Diskussion über diese Methoden angezeigt. Obwohl man bei der Debatte die Vorgehensweisen aller Regierungen in den Mittelpunkt rücken sollte, sollten zunächst die Methoden in den USA erörtert werden. Die aktuellsten Nachrichten bringen dies teilweise klar zum Ausdruck. Zudem sind sie auch Spiegelbild von etwas Zeitloserem. Die USA hat Vorbildfunktion, indem man dort das verfassungsrechtlich verankerte Recht auf freie Meinungsäußerung gewährleistet. Wir möchten dieses Recht ausüben. Da uns Juristen der amerikanischen Regierung daran hindern, der Öffentlichkeit weiterführende Informationen zur Verfügung zu stellen, sind wir nun auf den Justizminister angewiesen, der für den Schutz der Verfassung eintreten sollte.

Sobald wir die Erlaubnis erhalten, weitere Informationen zu veröffentlichen, werden wir diese sofort zur Verfügung stellen.

**********

Popular posts from this blog

[Excel] 문서에 오류가 있는지 확인하는 방법 Excel 문서를 편집하는 도중에 "셀 서식이 너무 많습니다." 메시지가 나오면서 서식을 더 이상 추가할 수 없거나, 문서의 크기가 예상보다 너무 클 때 , 특정 이름이 이미 있다는 메시지가 나오면서 '이름 충돌' 메시지가 계속 나올 때 가 있을 것입니다. 문서에 오류가 있는지 확인하는 방법에 대해서 설명합니다. ※ 문서를 수정하기 전에 수정 과정에서 데이터가 손실될 가능성이 있으므로 백업 본을 하나 만들어 놓습니다. 현상 및 원인 "셀 서식이 너무 많습니다." Excel의 Workbook은 97-2003 버전의 경우 약 4,000개 2007 버전의 경우 약 64,000개 의 서로 다른 셀 서식 조합을 가질 수 있습니다. 셀 서식 조합이라는 것은 글꼴 서식(예- 글꼴 종류, 크기, 기울임, 굵은 글꼴, 밑줄 등)이나 괘선(괘선의 위치, 색상 등), 무늬나 음영, 표시 형식, 맞춤, 셀 보호 등 을 포함합니다. Excel 2007에서는 1,024개의 전역 글꼴 종류를 사용할 수 있고 통합 문서당 512개까지 사용할 수 있습니다. 따라서 셀 서식 조합의 개수 제한을 초과한 경우에는 "셀 서식이 너무 많습니다." 메시지가 발생하는 것입니다. 그러나 대부분의 경우, 사용자가 직접 넣은 서식으로 개수 제한을 초과하는 경우는 드뭅니다. 셀 서식이 개수 제한을 넘도록 자동으로 서식을 추가해 주는 Laroux나 Pldt 같은 매크로 바이러스 에 감염이 되었거나, 매크로 바이러스에 감염이 되었던 문서의 시트를 [시트 이동/복사]하여 가져온 경우 시트의 서식, 스타일이 옮겨와 문제가 될 수 있습니다. "셀 서식이 너무 많습니다." 메시지가 발생하지 않도록 하기 위한 예방법 글꼴(종류, 크기, 색, 굵기, 기울임, 밑줄), 셀 채우기 색, 행 높이, 열 너비, 테두리(선 종류, ...

ASP.NET AJAX RC 1 is here! Download now

Moving on with WebParticles 1 Deploying to the _app_bin folder This post adds to Tony Rabun's post "WebParticles: Developing and Using Web User Controls WebParts in Microsoft Office SharePoint Server 2007" . In the original post, the web part DLLs are deployed in the GAC. During the development period, this could become a bit of a pain as you will be doing numerous compile, deploy then test cycles. Putting the DLLs in the _app_bin folder of the SharePoint web application makes things a bit easier. Make sure the web part class that load the user control has the GUID attribute and the constructor sets the export mode to all. Figure 1 - The web part class 2. Add the AllowPartiallyTrustedCallers Attribute to the AssemblyInfo.cs file of the web part project and all other DLL projects it is referencing. Figure 2 - Marking the assembly with AllowPartiallyTrustedCallers attribute 3. Copy all the DLLs from the bin folder of the web part...

How to control your World with Intune MDM, MAM (APP) and Graph API

VSS yedekleme testi nasıl yapılır Exchange üzerinde bulunan verilerin yedeklenmesi (backup) ve geri yüklenmesi (restore) baslibasina çok önemli bir konudur. Bir yedegin saglikli alinmasi kadar restore isleminin basarili bir biçimde yapilabilmesi de test edilmesi gereken önemli bir islem. Exchange destegi olan (aware) diye adlandirdigimiz yazilimlar exchange writer'lari kullanarak VSS teknolojisi ile yedek alirlar. Yedekleme esnasinda karsilasilan sorunlarin büyük bölümünün nedeni, yazilimlarin uyumsuzlugu ya da bu yazilimlardaki yanlis bir ayar olabilmektedir. Bunun tespiti için, yani yedek alma sirasinda sorunun VSS Writer'dan mi, disk sisteminden mi ve/veya yedekleme yazilimindan mi kaynaklandigini anlayabilmek için Betest aracini kullanabilirsiniz. BETEST, Windows SDK yada Volume Shadow Copy Service SDK 7.2 (sonraki versiyonlarda mevcut) içerisinde bulunan yardimci bir araçtir. Araci kolaylikla bulabilir ve kurabilirsiniz. Kurulum islemini exchange sunucunuz...

Comments

Post a Comment